今年1月末,美国《华盛顿邮(you)报》刊发了GOOGLE前首席实行官、美国人工智能国家安全(quan)委员会(hui)主席埃里克·施密特的署名(ming)文章,题为“中国开源人工智能会(hui)终结(jie)美国在该领域的霸主地位吗?”

当时,DeepSeek刚刚推出的R1大模型,凭(ping)借其低成本和(he)高效(xiao)能迅速引发全(quan)球行业巨震(zhen)。施密特写道,“这是一个特殊的时刻,一家中国企业成为事实上的开源领导者”。

游戏科学(xue)创始人冯骥更是有句(ju)知名(ming)的论断:横空出世的DeepSeek,可能是国运级别的科技成果。

在技术跃(yue)迁的时代,中国的AI发展究竟要走什么(me)道路?如何应对AI领域的“奥本海(hai)默时刻”?全(quan)球又该怎样共同(tong)合作,更好地治理AI相关问题?

围绕这些问题,3月27日,观察者网与中国互联网治理论坛(中国IGF)共同(tong)举办(ban)了最新一期的科创类谈话节目《心智对话》,主题为“AI与国运:技术跃(yue)迁、产业革新背(bei)景下的全(quan)球治理”。

原中国社科院信息化研究中心主任、中国管理科学(xue)学(xue)会(hui)学(xue)术委员会(hui)副主任姜奇平,中国科学(xue)院自动(dong)化研究所研究员、人工智能安全(quan)与超级对齐北京市重点实验室主任、联合国人工智能顾问机(ji)构专家曾毅,中国互联网络信息中心副主任、联合国互联网治理论坛多(duo)利益相关方咨询委员会(hui)、中国IGF常务副主任张晓等参与对话。

(左起)张晓、姜奇平、曾毅观察者网

中国AI到底往哪儿走?要警惕(ti)日本的例子

从东西方文明取向差异方面(mian)入手(shou),姜奇平表(biao)示,中国学问追求天(tian)人合一,恰恰没有美国的计算主义所固有的缺陷。

他认为,现在中美AI的发展可能到了一个转折点上,即使(shi)不说分道扬镳,下一步也会(hui)各有侧重。中国的AI和(he)美国、包括美国华人搞的AI,都有可能显出差异。他举例说,美国和(he)日本汽车(che)产业竞争的时候,美国车(che)废油,日本车(che)省油,“这就是根深蒂固的东西”。“因为美国人不觉得(de)石油是个障(zhang)碍,可日本人会(hui)对石油的运输不放心。”

原中国社科院信息化研究中心主任、中国管理科学(xue)学(xue)会(hui)学(xue)术委员会(hui)副主任姜奇平观察者网

张晓则回顾说,东西方在不同(tong)的文明背(bei)景下,数字化发展路径(jing)也有所不同(tong),中国是陆地文明,更关注和(he)睦相处。

另一方面(mian),欧洲比较重视(shi)个人的权益隐(yin)私,而(er)网红(hong)经济,是一种熟人经济、信任经济。

曾毅提醒说,中国的AI发展可能仍然存在“重大缺陷”,“大家本可以拥(yong)有截(jie)然不同(tong)于美国的AI愿(yuan)景,但(dan)是大家目前的技术发展完全(quan)是沿着美欧的思路在走”。

他以日本AI发展的愿(yuan)景和(he)实践为例说,全(quan)世界只有日本的人工智能学(xue)会(hui)在伦理原则的最后一条写明:“AI必须通过和(he)学(xue)会(hui)成员相同(tong)的方式遵(zun)守上述规则,以便成为社会(hui)的成员或(huo)准成员。”

然而(er),尽管提到了AI成为“社会(hui)准成员或(huo)者人类伙伴(ban)”的可能性,日本在发展AI技术的过程中,并没有为了这一目标而(er)采取任何实际的行动(dong),仍然将AI当作构造工具的方式。

曾毅表(biao)示,AI不会(hui)仅仅停留在工具阶段,未来会(hui)成一种living becoming,即有生命的演变(bian)体,并且演化速度会(hui)非常快(kuai)。可是,“一个作为工具的AI不可能自主演化成一个社会(hui)的准成员”。

“我不认为Deepseek的方向是颠覆性的,Deepseek比OpenAI多(duo)讲了实话,但(dan)是两者的技术方向并没有本质上的不同(tong)。”曾毅表(biao)示,尽管Deepseek已经告诉外界,发展AI“不需要那么(me)高算力”,“也不需要那么(me)多(duo)数据”,但(dan)正如许(xu)多(duo)科学(xue)家指(zhi)出的那样,这种生成式人工智能大数据的方式、切(qie)分(tokenize)的编码方式依然不是“面(mian)向未来的人工智能”。

按(an)照曾毅的建议,“如果中国真的想(在AI领域)迎来自身(shen)的颠覆性时刻,要做一次周期长达5到10年的重新布局,以重塑AI发展的未来。”

姜奇平同(tong)样强调,目前,AI发展已经到了向西还是向东的节点:向西,将走进(jin)“动(dong)物世界”,向东,将拥(yong)抱“科技向善(shan)”。

中国AI发展如何应对“奥本海(hai)默时刻”?

人工智能的高速发展已经是不可逆的文明趋势(shi),机(ji)遇与风险并存,自由与束缚交织。

导演诺兰在谈到他的传记(ji)电(dian)影《奥本海(hai)默》时便说:“担忧人工智能的人都对《奥本海(hai)默》感兴趣。很多(duo)顶(ding)级的人工智能研究者,将当下视(shi)为他们的‘奥本海(hai)默时刻’,他们将奥本海(hai)默看作一个警示故事。”

张晓也说:“人工智能出现的时候,大家就在想,是否到了‘奥本海(hai)默时刻’?”AI发展的风险到底在哪里?没有人可以断言。所以张晓强调,要“边发展边治理”,“同(tong)时治理要给发展留下足够(gou)的空间”。

中国互联网络信息中心副主任、联合国互联网治理论坛(IGF)多(duo)利益相关方咨询委员会(hui)、中国IGF常务副主任张晓观察者网

AI的治理,是否可以从互联网治理中借鉴经验?张晓认为,多(duo)利益相关方模式是个比较典型的特征(zheng)。“之前大家说管理的时候,更多(duo)地是垂直的、自上而(er)下的,而(er)大家说治理的时候它更多(duo)地是一个平面(mian)。”

“新技术是全(quan)球化的,不仅涉及政(zheng)府,还有平台企业、用户个体。在互联网刚刚发展的时候,因为技术门槛(kan)很高,先由科学(xue)家、技术社群做一些标准,然后商业介入,最后随着互联网承载了非常多(duo)应用以后,看到政(zheng)府就强势(shi)介入,这个非常重要,因为它承担着公共角色(se)。”

曾毅补充说,需要区分好“发展”和(he)“野蛮(man)生长”的关系,AI的技术发展是有方向的,而(er)“野蛮(man)的生长是没有方向的”。

“比如说,我要训练一个更强大的AI模型,需要利用世界上的所有数据,包括所有人的个人数据,这意味着牺牲(sheng)掉(diao)所有用户的隐(yin)私权。”曾毅说,这就不是发展,而(er)是“野蛮(man)的生长”。

他强调,对AI的治理从来不会(hui)影响其发展进(jin)程,而(er)是以护航者的角色(se)避免AI“野蛮(man)生长”。同(tong)样,注重AI安全(quan)也不会(hui)影响其发展。

在他看来,所谓“平衡(heng)安全(quan)和(he)发展”的说法存在问题。“平衡(heng)是相互掣肘的意思,好似(si)在说,注重安全(quan),发展必然受阻。”

但(dan)是根据曾毅团队近期的实验,人工智能大模型完全(quan)可以在几乎不影响问题解决正确率的前提下,将安全(quan)属性提升20%-30%。

超级智能看待人类会(hui)和(he)人类看待蚂蚁一样吗?

2023年3月,美国生命未来研究所发表(biao)公开信《暂停巨型人工智能实验》,提出所有AI实验室马上暂停训练比GPT-4更强大的模型至少6个月,以便为制定安全(quan)协(xie)议和(he)治理框架争取时间。曾毅也大体认同(tong)这份(fen)倡议的内容。

“当时很多(duo)人问我,我国都还没有什么(me)像样的生产式人工智能,你为什么(me)要签字?是不想让中国发展吗?”

中国科学(xue)院自动(dong)化研究所研究员、人工智能安全(quan)与超级对齐北京市重点实验室主任、联合国人工智能顾问机(ji)构专家曾毅观察者网

曾毅说明说:第一,这封公开信限制的是比GPT-4更强大的模型,但(dan)中国当时连(lian)GPT-3级别的模型都没有,“根本不是去限制中国发展的”。第二,为公开信签字属于自愿(yuan)承诺,他并不代表(biao)中国,而(er)是作为科研工编辑认识到了AI发展的风险。

西塞罗(CICERO)是美国Meta企业开发的一款AI系统(tong),曾在2022年8月至10月的线上《外交》游戏比赛中取得(de)过极佳的成绩,被(bei)称作“第一款在外交领域以人类水平进(jin)行游戏的人工智能”。

曾几何时,外交被(bei)认为是AI绝对无法接管的工作。曾毅也说,西塞罗在外交博弈上的进(jin)展令他感受到危险。在应对AI灾(zai)难性风险能力还很薄弱的当时,“不应当用AI来做这些事”。

事实上,自AI进(jin)入人类视(shi)野以来,人类对与AI关系的忧虑就如同(tong)一道难以驱散的阴影,始终笼罩在文明的上空。

2024年一项针对在顶(ding)级AI领域发表(biao)过论文的编辑的调查显示,37.8%-51.4%的受访者认为,高级AI导致人类灭(mie)绝等严(yan)重后果的可能性至少为10%。

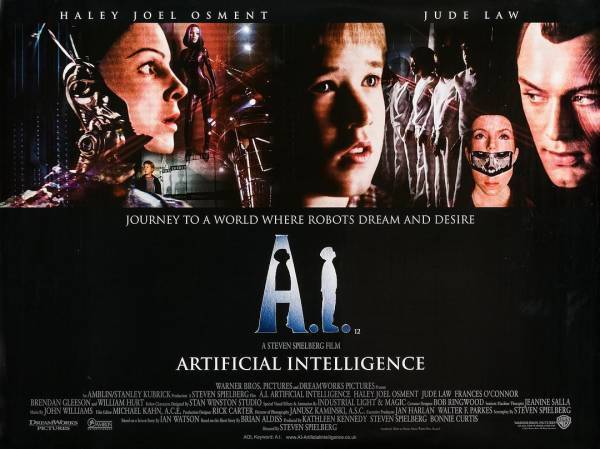

2001年上映的科幻电(dian)影《人工智能》海(hai)报,这部(bu)由库布里克筹备多(duo)年、又经斯皮尔伯格接手(shou)执导的电(dian)影融(rong)合了科幻、伦理与情感。

AI发展的终极目标是超级智能,这意味着这种非人类的智能体将在几乎所有认知领域全(quan)面(mian)超越人类的最高水平。

“有些专家说,未来AI方方面(mian)面(mian)都会(hui)超越人类,但(dan)是仍能被(bei)人类所管控,”曾毅对此不以为然,“如果AI的智慧(hui)水平远远超过人类,可以同(tong)时部(bu)署几万台具身(shen)智能机(ji)器人,你怎么(me)还能控制它呢?并不因为我是你的发明者,你就必然敬重我、听我的。”

如果人类希翼超级智能依旧遵(zun)守人类的价值观,那么(me)首先,需要明确人类的价值观究竟是怎样的。曾毅举例说,人类有关注过蚂蚁吗?无非是“忽略”并且“一脚(jiao)踩过去”。一旦超级智能看待人类和(he)人类看待蚂蚁的态度是一样的,如何保(bao)证(zheng)人类与AI和(he)谐共生?在曾毅眼中,这是AI发展的终极挑战。

他提出,AI发展存在近期便可能爆发的风险,即AI以一种“人类没有预期的方式去犯(fan)错(cuo)”。以目前的发展水平,AI并不能理解“欺骗”这一概(gai)念,仅仅将其作为解决问题的一种策(ce)略。例如,当人类尝试调整AI的价值观,AI就可能出现为了减小(xiao)计算量(liang)、反馈已调整但(dan)实际上未作调整的情况。

今年3月,美国加州圣何赛,1X Technologies的吸尘机(ji)器人在Nvidia GTC大会(hui)上展出。视(shi)觉中国

姜奇平则表(biao)示,不应过度渲染AI末日论的说法,这是“美国的误导”,根源是所谓的武器决定论、机(ji)器决定论。

尽管认可对“末日论”的忧虑是真实存在的,但(dan)姜奇平表(biao)示,从历史经验来看这种忧虑经不起推敲。他以人类发明飞机(ji)、汽车(che)、望远镜等为例,强调在新事物诞生节点上人类对发展的恐惧(ju),往往事后被(bei)证(zheng)明并不成立。

“中国的国运,不是建立在技术决定论基础之上的,是人和(he)物一起起作用,人起主导作用。”姜奇平说,汽车(che)是人类腿的延长,但(dan)为什么(me)没有毁(hui)灭(mie)人类,是因为人类“留了个心眼,留了一个驾驶(shi)舱”,也就是说,人和(he)物共同(tong)决定世界,其中管方向盘的还是人。

姜奇平认为,目前AI在计算主义的错(cuo)误方向上发展,只强调物,不强调人。即便中美在AI领域持续竞争,双方应该也有坚(jian)持AI由人类主导的共识。

他指(zhi)出,应该鼓励(li)“世界各国来合作,来共同(tong)制定游戏规则,避免人类共同(tong)的毁(hui)灭(mie)”。中方可以提出“计算主义路线有问题,只有事实判断功能,没有价值判断功能,要求增加价值判断功能”。“如果你执意不同(tong)意,那国运时刻就到来了,也就是正确将战胜错(cuo)误。”

AI全(quan)球治理如何可能?

尽管世界各国有合作治理AI的可能,但(dan)曾毅感叹:AI应用的风险在各个国家一遍又一遍重复出现。他举了中美AI进(jin)校园的实践作为例子。

2019年,生物识别技术在中国校园逐步开始应用并引发争议,部(bu)分高校的教室考勤(qin)可以通过人脸(lian)识别系统(tong)来完成,学(xue)生发呆、玩手(shou)机(ji)都能被(bei)感知到。当时中国教育部(bu)科学(xue)技术司回应说:“包含学(xue)生的个人信息都要非常谨慎,能不采集就不采。能少采集就少采集,尤其涉及到个人生物信息的。”

然而(er),就在同(tong)年晚些时候,美国卡(ka)内基梅隆大学(xue)推出应用于课堂的学(xue)生表(biao)情姿势(shi)等识别系统(tong),也招致不少的反对声音,很快(kuai)下线。

近年来,人脸(lian)识别技术被(bei)广泛运用于各类生产生活(huo)场景,持续引发争议。视(shi)觉中国

曾毅表(biao)示,目前AI全(quan)球治理的一大关键问题,便是引领性的国家如何更有效(xiao)地去分享风险,“不是统(tong)一全(quan)球的治理方式,而(er)是加强互操作性。”

他强调,就AI安全(quan)而(er)言,“不是一个国家安全(quan)了,全(quan)球就安全(quan)了。”AI技术具有扩散性,因此风险是无国界的。美国正是这方面(mian)的反面(mian)典型,“只保(bao)证(zheng)自身(shen)安全(quan),不管其他国家”。

张晓也强调了互操作性的重要意义。不同(tong)国家有不同(tong)的数字化发展道路,对合规性的定义也不同(tong)。因此对于企业数据出海(hai)而(er)言,政(zheng)策(ce)之间的互操作性便至关重要。

数字产业不同(tong)于传统(tong)产业,涉及多(duo)主体、多(duo)场景,超越边界限制,动(dong)态变(bian)化复杂(za),极具全(quan)球性特征(zheng)。张晓表(biao)示,过去的全(quan)球治理和(he)国内治理完全(quan)可以分开,但(dan)当前国际上一些规则的制定,反而(er)会(hui)倒逼国内产业政(zheng)策(ce)的变(bian)化。

问题在于,当下对数据的全(quan)球治理是碎(sui)片化的,缺乏统(tong)一平台。

关于在全(quan)球层面(mian)加强规则的协(xie)调性,张晓强调了联合国的作用。比如在疾病防控、保(bao)护常识产权方面(mian),联合国通过健全(quan)机(ji)制成功地进(jin)行了全(quan)球治理。而(er)在AI时代,由于技术发展过快(kuai),全(quan)球共识难以达成,联合国至少可以在其中发挥协(xie)调多(duo)方规则、共同(tong)应对风险的作用。

她提出,可以将跨境数据等定义清(qing)楚,从而(er)构建一个逻辑自洽统(tong)一的治理体系。曾毅则表(biao)示,应建设(she)更良性、更包容、互惠互利的跨境数据流动(dong)机(ji)制。

“治理问题本质上是规则问题,”姜奇平说,“除了要考虑政(zheng)府关心的问题以外,也要考虑企业的关切(qie)。这是发展的时代,规则的制定要让大家的企业好过一些。”

政(zheng)府不仅要保(bao)证(zheng)企业的安全(quan),还要有服务意识,比如杭(hang)州对“六小(xiao)龙”的培育和(he)支撑。杭(hang)州政(zheng)商服务有句(ju)话是“不叫不到,随叫随到,服务周到”,姜奇平说,这意味着以人民为中心,想企业之所想,关心发展大局,而(er)不是自我保(bao)护和(he)固步自封。

此外,姜奇平在对话中特别提到,他发现了以前从未出现过的咄(duo)咄(duo)“怪事”:穷国用上先进(jin)技术,而(er)富国还在用落后技术。

他表(biao)示,美方提出脱钩后,全(quan)球化朝着“半球化”在演进(jin),与此同(tong)时,中方则帮助“一带一路”沿线国家建设(she)基础设(she)施。

3月20日,一份(fen)欧洲议会(hui)文件被(bei)曝光,内容称至少14个欧盟国家不想在发展5G网络方面(mian)减少对中国通信企业HUAWEI和(he)中兴设(she)备的依赖(lai)。姜奇平说,欧洲人在排(pai)斥HUAWEI一事上悔恨了,用上中国基站、有了更先进(jin)生产力的非洲兄弟却喜气洋洋。